9月3-6日にスペイン・バルセロナで開催された ACM MobileHCI 2018 に参加してきたのでその報告。

MobileHCIとは

Conference on Human-Computer Interaction with Mobile Devices and Services (MobileHCI) は、その名の通りモバイル端末とサービス間における人間とコンピューターのインタクラションについての会議です。ACM(Association for Computing Machinery)SIGCHIにサポートされており、今回で20回目の開催(詳しくはこちら)。オープン二ングでは、20年前との変化についても触れられていました。会場は、Pompeu Fabra Universityで、有名なサクラダファミリアに徒歩で行ける、バルセロナのど真ん中にある大学です。

これまでもMobileHCIで発表された論文はチェックしていましたが、学会自体に参加したことは無かったので、非常に楽しみにしていた会議の一つです。今回はデモセッションにてSenbayと言うセンシングプラットフォームを発表してきました。(そしてなんと、Honorable Mention Awardを受賞!)

[発表論文]

Yuuki Nishiyama, Anind K. Dey, Denzil Ferreira, Takuro Yonezawa, and Jin Nakazawa. 2018. Senbay: a platform for instantly capturing, integrating, and restreaming of synchronized multiple sensor-data streams. In Proceedings of the 20th International Conference on Human-Computer Interaction with Mobile Devices and Services Adjunct (MobileHCI ’18). ACM, New York, NY, USA, 291-291. DOI: https://doi.org/10.1145/3236112.3236154

プログラム

- 一日目:Workshops

- 二日目:Opening + Keynote1 + Session1-5 + Demos&Posters

- 三日目:Session6-10 + Panel + Conference Dinner

- 四日目:Session11-12 + Keynote2

Opening

メイン会場の風景。

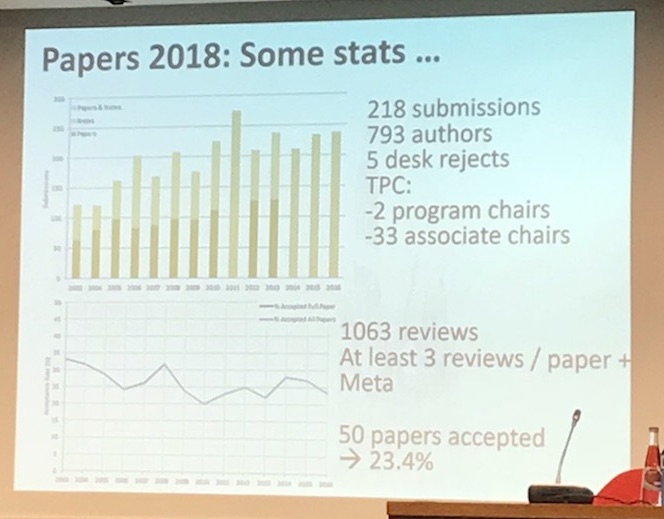

今年は、218本の論文投稿があり、50本がアクセプト。採択率は23.4%。

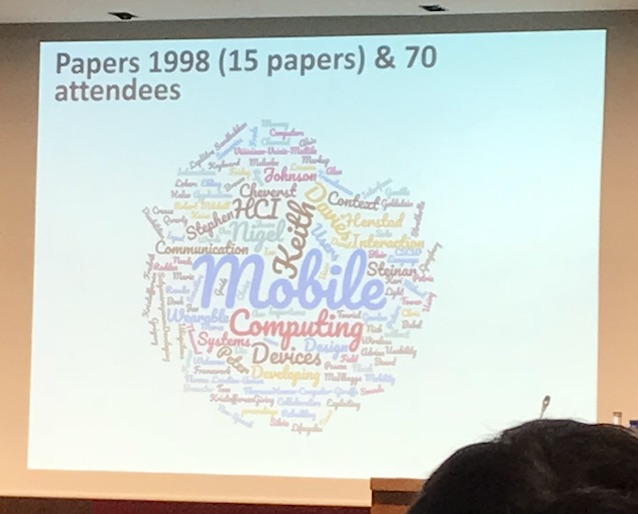

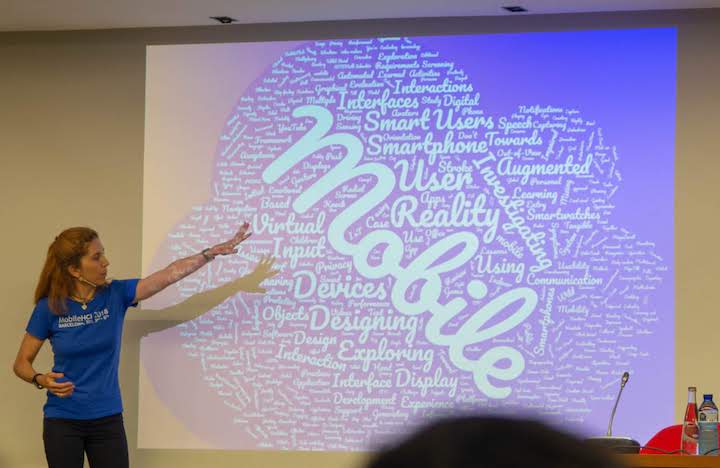

1998年と2018年の投稿論文から作成したタグクラウドを比較。SmartphoneやVR、ARなど20年前には存在しなかったモノが登場している。

国別に参加者を見ると、アメリカ・イギリス・ドイツ・韓国が多く、その次に日本、スペイン、フィンランド。日本からも北海道大学とYahoo Japan、同志社大学のチームが発表に来ていました。

Keynote 1

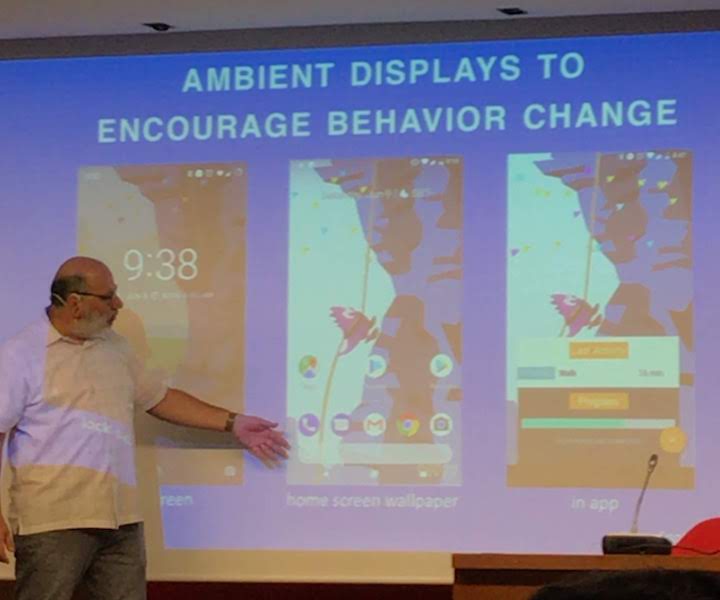

Keynote一人目は、Prof. James A. Landay。スタンフォード大学の教授で、私がよく論文を引用するDr. Sunny Consolvoの師匠。モバイルデバイス x 行動変容研究の第一人者で、UbiFitGardenはこの分野なら誰もが知る研究。Ambientに情報を表示した方が、普通にグラフを見せるより、「長期的」な行動変容に繋がる傾向があるとのこと。さらに「ストーリー性」を追加するとどんな効果があるかや、ビルの内装への応用にもチャレンジ中。少し方向は変わるが、小学生向けの屋外でのインタラクティブ学習ツール(ツールはある完成したが、それを使いこなせるか、または興味を持たすことができるかは、教員や親に依存する)やドローン・ヒューマンインタフェースなども開発中。ビジョン動画を作って共有するのは非常に戦略的だと感じた。

https://www.landay.org/

Keynote 2

Keynote2は、Prof. Cynthia Breazeal。MITの准教授で、Social Robotsの第一人者。TEDトークにも登壇した事がある先生。これまでの研究成果を生かして、Jiboと言うロボットの開発・販売もしている。Social Robotsは、SeniorsやChildren、Families、B2B2Cなど幅広い分野で重要になってくるはず。その実現には、ただ正確に動くロボットを作るだけでなく、「人間との共存のための技術」が必要で、彼女はその調査・研究・開発を行なっている。キーノートでは、これまでの観察や実装・実験内容が紹介された。”共同作業中の子供の同士の会話(相槌を打つタイミングや目線など)”を観察し、それを記述(コード化)し、再現できるロボットを作成、その後”子供とロボットとの共同作業+会話”実験を行うと言う非常にオーソドックスな研究方法。ロボットの実装だけでも大変なのに、観察から実装・実験までしっかり計画的に行なっているのは圧巻。既存のデータセットでは、子供の会話検知の精度が悪かったので、一からアルゴリズムを作成したみたい。

今回はここまで。各セッションと自分の発表については次の記事で書こうと思います。